使い始めが2024年という、そこそこ息が長いデッキのマナカーブやシナジーを元に調整を重ねています。

統率者

《リスの将軍、サワギバ/Chatterfang, Squirrel General(MH2)》

デッキ

クリーチャー

- 《大釜の使い魔/Cauldron Familiar(ELD)》

- 《骨術師の達人/Osteomancer Adept(BLB)》

- 《ズーラポートの殺し屋/Zulaport Cutthroat(BLC)》

- 《ネイディアの夜刃/Nadier's Nightblade(BLC)》

- 《無情な無頼漢/Ruthless Knave(XLN)》

- 《実験的な菓子職人/Experimental Confectioner(WOE)》

- 《悲哀の徘徊者/Woe Strider(BLC)》

- 《巣穴の魂商人/Warren Soultrader(MH3)》

- 《無慈悲な略奪者/Pitiless Plunderer(RIX)》

- 《無情な屍技術師/Ruthless Technomancer(NEC)》

- 《ヘイゼルの醸造主/Hazel's Brewmaster(BLC)》

- 《溜め込む親玉/Hoarding Broodlord(MOM)》

- 《エルフの神秘家/Elvish Mystic(TSR)》

- 《金のガチョウ/Gilded Goose(MOC)》

- 《ラノワールのエルフ/Llanowar Elves(_BR)》

- 《極楽鳥/Birds of Paradise(RVR)》

- 《森を護る者/Sylvan Safekeeper(MH3)》

- 《茨越えの餌あさり/Thornvault Forager(BLB)》

- 《献身のドルイド/Devoted Druid(UMA)》

- 《裕福な亭主/Prosperous Innkeeper(BLC)》

- 《小走り樫/Scurry Oak(MH2)》

- 《不屈の補給兵/Tireless Provisioner(BLC)》

- 《リスの小走り/Scurry of Squirrels(BLC)》

- 《ペレグリン・トゥック/Peregrin Took(LTR)》

- 《秘密を知るもの、トスキ/Toski, Bearer of Secrets(MKC)》

- 《終わりなき巣網のアラスタ/Arasta of the Endless Web(BLC)》

- 《永久の証人/Timeless Witness(MH2)》

- 《深き森の隠遁者/Deep Forest Hermit(BLC)》

- 《悪魔の職工/Fiend Artisan(IKO)》

- 《根花のヘイゼル/Hazel of the Rootbloom(BLC)》

- 《歩行バリスタ/Walking Ballista(AER)》

- 《アカデミーの整備士/Academy Manufactor(BLC)》

- 《カルドーサの鍛冶場主/Kuldotha Forgemaster(SOM)》

- 《マイアの戦闘球/Myr Battlesphere(TDC)》

インスタント

- 《命取りの論争/Deadly Dispute(BLC)》

- 《切断マジック/Saw in Half(BLC)》

- 《新緑の命令/Verdant Command(MH2)》

- 《蓄え放題/Cache Grab(BLB)》

- 《召喚の調べ/Chord of Calling(M15)》

- 《暗殺者の戦利品/Assassin's Trophy(ACR)》

- 《ウィンドグレイスの裁き/Windgrace's Judgment(BLC)》

ソーサリー

- 《発掘/Unearth(A25)》

- 《群がり庭の虐殺/Swarmyard Massacre(BLC)》

- 《根鋳造の弟子入り/Rootcast Apprenticeship(BLC)》

- 《大渦の脈動/Maelstrom Pulse(BLC)》

エンチャント

- 《清掃人の才能/Scavenger's Talent(BLB)》

- 《アクロゾズの約定/Promise of Aclazotz(LCC)》

- 《想起の拠点/Bastion of Remembrance(BLC)》

- 《美食家の才能/Gourmand's Talent(BLC)》

- 《パンくずの道標/Trail of Crumbs(ELD)》

- 《殺しのサービス/Killer Service(NCC)》

- 《イトリモクの成長儀式/Growing Rites of Itlimoc(XLN)》

- 《似通った生命/Parallel Lives(WOT)》

- 《陰湿な根/Insidious Roots(MKM)》

アーティファクト

- 《太陽の指輪/Sol Ring(BLC)》

- 《恐竜の遺伝子/Dino DNA(REX)》

- 《魔女のかまど/Witch's Oven(ELD)》

- 《頭蓋骨絞め/Skullclamp(BLC)》

- 《アシュノッドの供犠台/Ashnod's Altar(4ED)》

- 《ヌカコーラ自動販売機/Nuka-Cola Vending Machine(PIP)》

- 《前兆の時計/Clock of Omens(5DN)》

- 《旗印/Coat of Arms(EXO)》

- 《囀り吐き/Chitterspitter(BLC)》

プレインズウォーカー

- 《飢餓の潮流、グリスト/Grist, the Hunger Tide(MH2)》

バトル

- 《イコリアへの侵攻/Invasion of Ikoria(MOM)》

土地

- 《沼/Swamp》

- 《沼/Swamp》

- 《沼/Swamp》

- 《沼/Swamp》

- 《沼/Swamp》

- 《沼/Swamp》

- 《沼/Swamp》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《見捨てられたぬかるみ、竹沼/Takenuma, Abandoned Mire(NEO)》

- 《ゴルガリの腐敗農場/Golgari Rot Farm(RAV)》

- 《疾病の神殿/Temple of Malady(BLC)》

- 《森林の墓地/Woodland Cemetery(TDC)》

- 《黄昏のぬかるみ/Twilight Mire(TDC)》

- 《ラノワールの荒原/Llanowar Wastes(TDC)》

- 《緑ばんだ沼/Viridescent Bog(BLC)》

- 《汚れた森/Tainted Wood(BLC)》

- 《草むした墓/Overgrown Tomb(RAV)》

- 《屍花の交錯/Necroblossom Snarl(BLC)》

- 《風切る泥沼/Hissing Quagmire(OGW)》

- 《眠らずの小屋/Restless Cottage(WOE)》

- 《不気味な辺境林/Grim Backwoods(BLC)》

- 《群がりの庭/Swarmyard(TSR)》

- 《風変わりな果樹園/Exotic Orchard(BLC)》

- 《祖先の道/Path of Ancestry(BLC)》

- 《統率の塔/Command Tower(BLC)》

- 《新緑の地下墓地/Verdant Catacombs(ZEN)》

- 《成長の揺り篭、ヤヴィマヤ/Yavimaya, Cradle of Growth(MH2)》

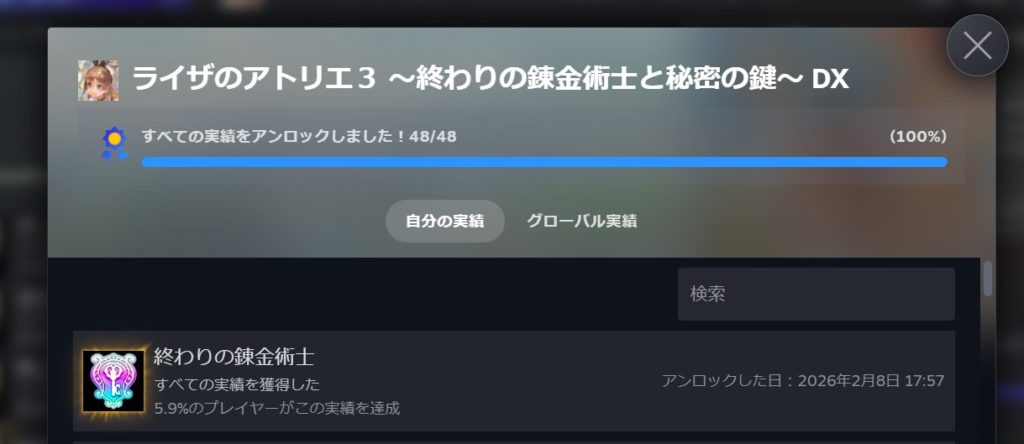

お気に入りのデッキですが、ここ半年回していなかったのは明確な理由がありました。

「Geminiの画像生成により、全てのトークンを一新する必要があったため」

上記リストの太字はトークン生成/トークン生成を強化するもの。

それだけに、この一仕事を終えてホッとしています。