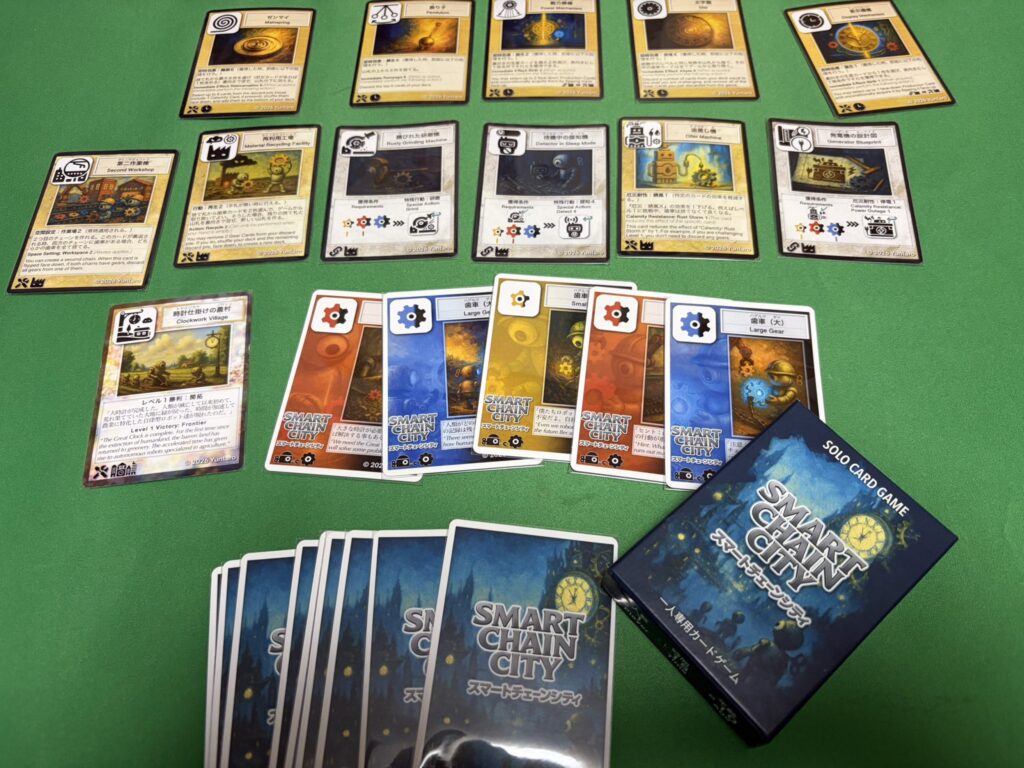

1年前に買ったまま放置していたデッキをようやく組めました。

生けるエネルギー:改

ネットで見た改造案を元に、進化とトークン戦略。ゲームチェンジャーを一切入れないブラケット2に抑えています。

統率者

- 《光輝の創造者、サヒーリ/Saheeli, Radiant Creator(DRC)》

デッキ

クリーチャー

- 《オーロラの変幻者/Aurora Shifter(M3C)》

- 《乱動の地図作り/Roil Cartographer(MH3)》

- 《潮の星、京河/Keiga, the Tide Star(CLB)》

- 《破片撒きのスフィンクス/Sharding Sphinx(MOC)》

- 《蜥蜴丸/Lizard Blades(NEO)》

- 《改革派の霊気砲手/Aethertorch Renegade(KLD)》

- 《極楽鳥/Birds of Paradise(RVR)》

- 《金脈のハイドラ/Goldvein Hydra(OTJ)》

- 《恐竜の卵/Dinosaur Egg(LCC)》

- 《目ざとい新人/Sharp-Eyed Rookie》

- 《獣性を築く者/Architect of the Untamed(DRC)》

- 《警戒するラッドスタッグ/Watchful Radstag(PIP)》

- 《進化の証人/Evolution Witness(MH3)》

- 《世界魂の代弁者、ニッサ/Nissa, Worldsoul Speaker(DRC)》

- 《浄化のドルイド/Druid of Purification(DRC)》

- 《ピーマの先駆者/Peema Trailblazer(DRC)》

- 《猛る霊気コブラ/Rampaging Aetherhood(DRC)》

- 《サイクロプスの超伝導師/Cyclops Superconductor(MH3)》

- 《ティラニッド・プライム/Tyranid Prime(40K)》

- 《崇高な飛行士/Empyreal Voyager(KLD)》

- 《ならず者の精製屋/Rogue Refiner(DRC)》

- 《つむじ風の巨匠/Whirler Virtuoso(DRC)》

- 《双子唱者、アドリックスとネヴ/Adrix and Nev, Twincasters(MKC)》

- 《フラクタルの花、エシックス/Esix, Fractal Bloom(MKC)》

- 《テルカーの技師、ブルーディクラッド/Brudiclad, Telchor Engineer(M3C)》

- 《整備長、ピア・ナラー/Pia Nalaar, Chief Mechanic(DRC)》

- 《極楽の羽ばたき飛行機械/Ornithopter of Paradise(DRC)》

- 《静電気式打撃体/Electrostatic Pummeler(KLD)》

- 《歩行格納庫の自動機械/Stridehangar Automaton(DRC)》

- 《ワームとぐろエンジン/Wurmcoil Engine(SOM)》

- 《三重の稲妻巨人/Threefold Thunderhulk(SOC)》

インスタント

- 《語りの調律/Tune the Narrative(MH3)》

- 《秘儀の否定/Arcane Denial(WOC)》

- 《不許可/Disallow(DRC)》

- 《混沌のねじれ/Chaos Warp(WHO)》

- 《エレクトロサイフォン/Electrosiphon(PIP)》

ソーサリー

- 《霊気との調和/Attune with Aether(KLD)》

- 《自然の知識/Nature's Lore(S99)》

- 《冒涜の行動/Blasphemous Act(VOC)》

- 《慮外な押収/Confiscation Coup(DRC)》

アーティファクト

- 《太陽の指輪/Sol Ring(DRC)》

- 《改良式鋳造所/Retrofitter Foundry(DRC)》

- 《稲妻のすね当て/Lightning Greaves(TDC)》

- 《抽出機構/Decoction Module(M3C)》

- 《好奇のタリスマン/Talisman of Curiosity(DRC)》

- 《秘儀の印鑑/Arcane Signet(ZNC)》

- 《独創のタリスマン/Talisman of Creativity(WHO)》

- 《織木師の組細工/Woodweaver's Puzzleknot(KLD)》

- 《パンハモニコン/Panharmonicon(DRC)》

- 《霊気池の驚異/Aetherworks Marvel(DRC)》

- 《ウギンのきずな/Ugin's Nexus(KTK)》

- 《ゴンティの霊気心臓/Gonti's Aether Heart(M3C)》

- 《特製の闘車/Bespoke Battlewagon(MH3)》

- 《模倣メカ/Imposter Mech(NEC)》

- 《秘密の複製機/Esoteric Duplicator(BIG)》

- 《世界歩きの兜/Worldwalker Helm(BIG)》

- 《イゼットの発電装置/Izzet Generatorium(MH3)》

エンチャント

- 《革新の時代/Era of Innovation(DRC)》

- 《テフェリーのヴェール/Teferi's Veil(WTH)》

- 《倍増の季節/Doubling Season(PZA)》

- 《降霜断崖の包囲/Frostcliff Siege(TDM)》

プレインズウォーカー

- 《崇高な工匠、サヒーリ/Saheeli, Sublime Artificer(WAR)》

土地

- 《島/Island》

- 《島/Island》

- 《島/Island》

- 《島/Island》

- 《山/Mountain》

- 《山/Mountain》

- 《山/Mountain》

- 《山/Mountain》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《森/Forest》

- 《焦熱島嶼域/Fiery Islet(WHO)》

- 《天啓の神殿/Temple of Epiphany(WHO)》

- 《嵐削りの海岸/Stormcarved Coast(WHO)》

- 《凍沸の交錯/Frostboil Snarl(DRC)》

- 《シヴの浅瀬/Shivan Reef(TDC)》

- 《溢れ出た区画/Overflowing Basin(DRC)》

- 《ヤヴィマヤの沿岸/Yavimaya Coast(C20)》

- 《繁殖池/Breeding Pool(DIS)》

- 《内陸の湾港/Hinterland Harbor(PIP)》

- 《冠水樹林帯/Waterlogged Grove(WHO)》

- 《蔦明の交錯/Vineglimmer Snarl(WHO)》

- 《隠れた茂み/Sheltered Thicket(WHO)》

- 《根縛りの岩山/Rootbound Crag(XLN)》

- 《カープルーザンの森/Karplusan Forest(TDC)》

- 《霊気拠点/Aether Hub(M3C)》

- 《無声開拓地/Silent Clearing(MH1)》

- 《風変わりな果樹園/Exotic Orchard(WOC)》

- 《産業の塔/Spire of Industry(DRC)》

- 《祖先の道/Path of Ancestry(TDC)》

- 《統率の塔/Command Tower(ZNC)》

- 《ケトリアのトライオーム/Ketria Triome(IKO)》

- 《ヘリオス1/HELIOS One(PIP)》

- 《アカデミーの廃墟/Academy Ruins(MMA)》

- 《霧深い雨林/Misty Rainforest(ZNE)》

あなたが工匠(Artificer)やアーティファクトである呪文1つを唱えるたび、(E)(エネルギー(energy)・カウンター1個)を得る。

あなたのターンの戦闘の開始時に、(E)(E)(E)を支払ってもよい。そうしたとき、あなたがコントロールしているパーマネント1つを対象とする。他のタイプに加えて速攻を持つ5/5のアーティファクト・クリーチャーであることを除き、それのコピーであるトークン1体を生成する。次の終了ステップの開始時に、そのトークンを生け贄に捧げる。

という統率者。高名な者、ミシュラと似たような挙動ですが

- パーマネントなら何でもいい

- コピー先とコピー元は同名のトークン

というのが微妙に違います。なので、

- 潮の星、京河をコピー→レジェンドルールにより墓地へ→相手のクリーチャーを永続的に奪う

- 恐竜の卵をコピー→勝手に死亡するので勝手に発見5が誘発

など、結構面白い動きができそうです。