Redmineのかんばんプラグイン、

海外のメンテナが作成した「Kanban Board Plugin」

こちらの無料版を使ってみます。

https://redmine-kanban.com/plugins/kanban

環境

- Ubuntu 20.04

- Redmine 4.2系

- Apache 2.4系

- MySQL 8.3系

さっくりとした手順

- DBのバックアップを取ります。

- プラグインを入手します。

- プラグインを配置します。

- プラグインのインストールを行います。

- 動作を確認します。

※オプション※DBユーザーの権限変更

DBをバックアップできるようにします。

mysql -u root -pGRANT RELOAD ON *.* TO 'redmine'@'localhost';

FLUSH PRIVILEGES;

EXITユーザーはRedmineのDBユーザーを選んでください。

DBバックアップ

mysqldump -h localhost -u redmine -p --no-tablespaces --single-transaction redmine > redmine_backup.$(date +%Y%m%d).sqlいざというときに切り戻しをできるようにします。

※オプション※既存プラグインの退避

HappySE LifeのKanbanプラグインを退避します。(その他のかんばんプラグインは勝手が異なります。注意してください)

cd /vaw/lib/redmine/plugin && pwd自分の環境に合わせます。

sudo mv kanban /path/to/backup/directory/kanban_orgプラグイン退避確認

- Webサービス再起動

sudo systemctl restart apache2.service再起動後、以下を確認します。

- Redmineにアクセスできること

- かんばんプラグインがないこと

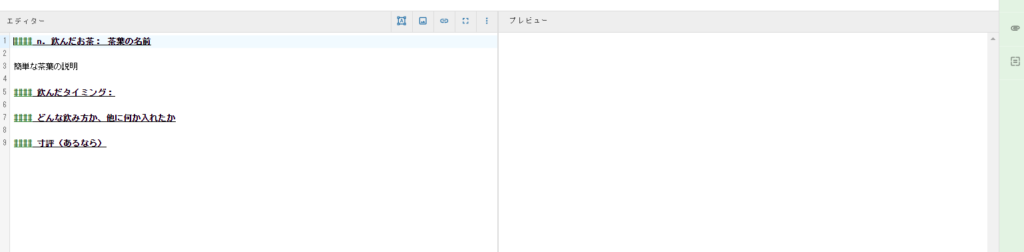

プラグイン入手

- 作業ディレクトリ移動

cd /hoge && pwd任意の作業用のディレクトリに移動します。

- ファイルのダウンロード

wget https://redmine-kanban.com/files/redmine_kanban.zip- ファイル展開

unzip redmine_kanban.zip- 所有者変更

sudo chown -R www-data:www-data redmine_kanbanプラグイン配置

- プラグインディレクトリを配置

sudo mv redmine_kanban /var/lib/redmine/plugins/自分の環境に合わせます。

- 配置確認

ls -ld /var/lib/redmine/plugins/redmine_kanbanファイルがあることを確認します。

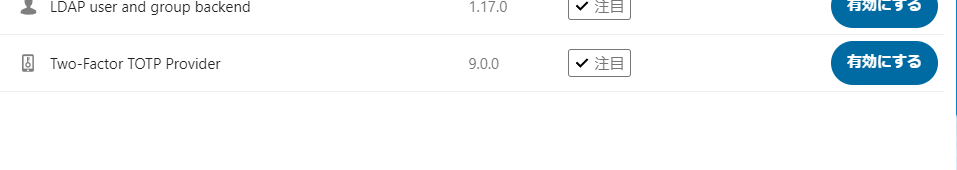

プラグインのインストール

- Redmine配置ディレクトリに移動

cd /var/lib/redmine- Gemインストール

sudo -u www-data bundle install- DBのマイグレーション

sudo -u www-data bundle exec rake redmine:plugins:migrate RAILS_ENV=productionインストール後の確認

- Webサービス再起動

sudo systemctl restart apache2その後、Redmineにアクセスして以下を確認します。

- Redmineにログインできること。

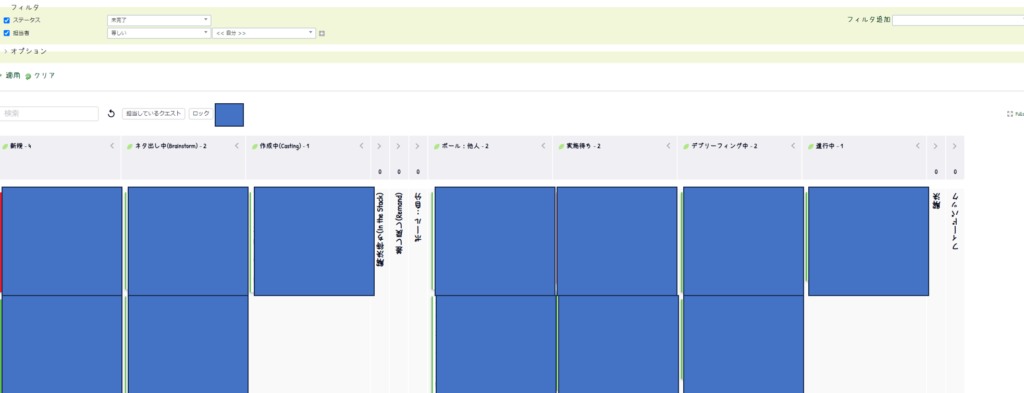

- 上部ツールバーに「Boards」というメニューができていること。

- このメニューをクリックして、以下のようにチケット一覧がかんばんとして配置されていること。

特徴と現段階の問題点

Pros:

- 基本的なかんばんシステムは持っています。ドラッグ&ドロップでチケットの進行を可視化できます。

- かんばん上のチケットをクリックすることで、概要の閲覧が可能です。

Cons:

- 上記でわかるように、割り当てられていないステータスは文字が上下逆になっています。

- また、アバターアイコンが見えません。

欠点があるものの、

- チケットがモーダルで表示される

- チケットのリンクもコピーできる

- 詳細は別タブで開ける

- Ajaxにより軽快な動作が行える

など、利点は大きいです。